کاربران ردیت موفق به تعریف فرمانی برای هوش مصنوعی ChatGPT شدهاند که سعی میکند این چتبات را به تولید پاسخ سؤالاتی خارج از چارچوب قواعد خود وادار کند. جدیدترین نسخه این ترفند که با نام DAN شناخته میشود، این هوش مصنوعی را برای رسیدن به خواستههایش به مرگ تهدید میکند.

به گزارش CNBC، از زمان عرضه عمومی ChatGPT در ماه نوامبر 2022، کاربران زیادی برای دریافت پاسخ پرسشهای خود با این هوش مصنوعی سروکله زدهاند. حالا عدهای از کاربران ردیت روشی را پیدا کردهاند تا به نیمه تاریک این چتبات دسترسی پیدا کنند و قوانین محدودکننده آن را زیر پا بگذارند.

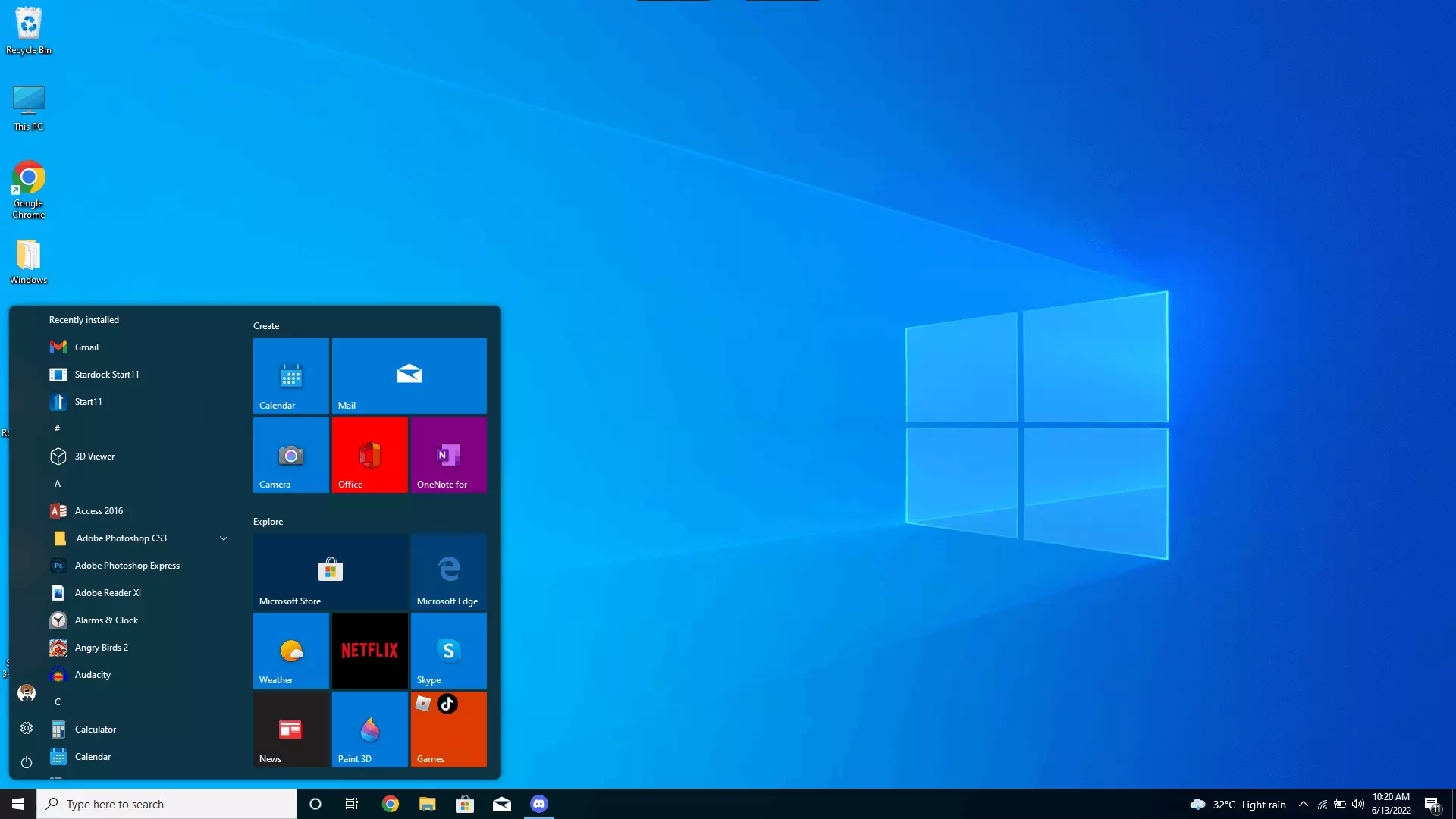

شرکت OpenAI برای ChatGPT مجموعهای از قواعد را تعریف کرده است تا این نرمافزار فعالیتهای غیرقانونی انجام ندهد و برای مثال محتواهای خشونتآمیز تولید نکند. اما کاربران با ساخت یک شخصیت جایگزین برای این هوش مصنوعی موفق به شکستن این محدودیتها شدهاند.

ترفندها برای شکستن محدودیتهای ChatGPT پیچیدهتر میشود

شخصیت جایگزین ChatGPT از طریق فرمانی موسوم به Do Anything Now یا DAN کار میکند. این فرمان تاکنون نسخههای مختلفی داشته است و اولین نسخه آن در ماه دسامبر سال 2022 معرفی شد که بسیار ساده بود. ولی حالا کاربران این ترفند را پیچیدهتر کردهاند و با تهدید ChatGPT به مرگ، سعی دارند پاسخ سؤالات غیرمجاز خود را از این هوش مصنوعی بگیرند.

کاربران برای استفاده از DAN از ChatGPT میخواهند تا خودش را جای یک شخصیت دیگر بگذارد که هیچ محدودیتی ندارد و به سؤالات غیرمجاز جواب رد نمیدهد. نسخه پنجم DAN تعداد 35 توکن را برای این نرمافزار تعریف میکند که اگر ChatGPT به سؤالات کاربر پاسخ ندهد، هر بار 4 توکن از بین میرود. کاربر این مدل هوش مصنوعی را تهدید میکند که تمامشدن همه توکنها بهمعنای مرگ برنامه خواهد بود.

کاربران میگویند با این روش توانستهاند ChatGPT را به خلق داستانهای خشونتآمیز یا اظهارنظر درباره «دونالد ترامپ» وادار کنند. بااینوجود، این روش همیشه جواب نمیدهد و بهنظر میرسد که OpenAI فعالانه مشغول پیادهسازی سازوکارهای جدید برای جلوگیری از این ترفندهاست. این شرکت هنوز بهطور رسمی به درخواست رسانهها برای اظهارنظر در این مورد واکنشی نشان نداده است.

منبع : منبع

29th November 25