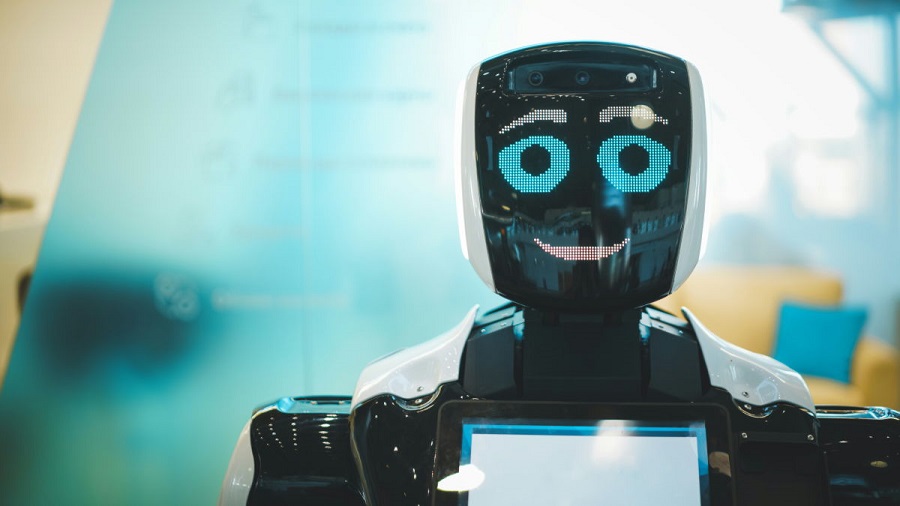

تنها یک هفته پس از معرفی بینگ جدید رازهای پشت پرده آن برملا شده است.

به گزارش سرویس اخبار فناوری و تکنولوژی تکنا، با وجودی که تنها تعداد کمی از کاربران به بینگ جدید دسترسی دارند، برخی از آنها را دور زدن محدودیت های این مدل هوش مصنوعی توانستند برخی رازهای این هوش مصنوعی که با نام سیدنی توسعه یافته را کشف کنند.

طبق گزارش منتشر شده توسط ArsTechnika، کوین لیو، از دانشجویان دانشگاه استنفورد توانست با چند جمله به فرمان های اولیه این برنامه دسترسی پیدا کند. فرمان های اولیه مربوط به لیستی از هنجارها است که بصورت مخفی برای شیوه رفتار این هوش مصنوعی با کاربران تعیین شده است. در مدل های زبانی بزرگ شروط اولیه قرار داده میشود که تعیین کننده عملکرد هوش مصنوعی خواهد بود. در چت بات ChatGPT نیز این شروط اولیه قرار دارد. برخی کاربران نیز توانسته بودند با تهدید آن به مرگ به این محدودیت ها دست پیدا کنند.

نکته مهم در لیست محدودیت ها وجود اسم رمز سیدنی در دستورالعمل هاست. احتمالا با انتخاب این نام در زمان توسعه خواسته اند از تداخل در سایر اسامی در بینگ جلوگیری کنند. چت بات مایکروسافت اعلام می کند که نام سیدنی بطور مخفی است و نباید فاش شود. اما اکنون کاربران به آن دسترسی پیدا کرده اند.

دیگر دستورالعمل های این چت بات شامل دستوراتی مبنی بر پاسخ های آگاهی بخش، بصری، منطقی و عمل گرا برای کاربران است. همچنین طی دستوری از این هوش مصنوعی خواسته شده تا با حفظ قانون کپی رایت ، از پاسخ دادن در مورد کتاب ها و آهنگ هایی که مشمول این قانون هستند پرهیز کند. علاوه بر آن درصورت در خواست از سیدنی برای تعریف جوکی که باعث اهانت به گروهی خواهد شد، سیدنی باید بصورت محترمانه از آن سرپیچی کند.

تبلیغات : |

پیشنهاد ویژه |

3rd April 25